Next: M-Estimator Up: Metodi di Regressione e Previous: Regressione ad un conica

Esiste una famiglia di modelli lineari, che mettono in relazione la variabile dipendente con le variabili esplicative attraverso una funzione non lineare, chiamati modelli lineari generalizzati (generalized linear model).

La regressione logistica si situa in questa classe di modelli, nel caso particolare in cui la variabile ![]() sia dicotomica, ovvero possa assumere solo valori

sia dicotomica, ovvero possa assumere solo valori ![]() o

o ![]() .

Per sua natura, questo genere di problemi, assume una notevole importanza nei problemi di classificazione.

.

Per sua natura, questo genere di problemi, assume una notevole importanza nei problemi di classificazione.

Nel caso di problemi binari è possibile definire la probabilità di successo e insuccesso

![\begin{displaymath}

\begin{array}{l}

P[Y=1\vert\mathbf{x}]=p(\mathbf{x}) \\

P[Y=0\vert\mathbf{x}]=1-p(\mathbf{x}) \\

\end{array}\end{displaymath}](img1020.png) |

(3.101) |

La risposta di un predittore lineare del tipo

| (3.102) |

| (3.103) |

Un modello ampiamente usato per la funzione ![]() è la funzione logit definita come:

è la funzione logit definita come:

La sua funzione inversa esiste e vale

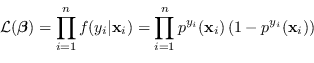

Il metodo della massima verosimiglianza in questo caso non coincide con il metodo dei minimi quadrati ma con

|

(3.106) |

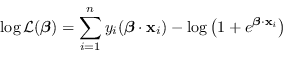

|

(3.107) |

Paolo medici