Next: Regressione a una circonferenza Up: Regressioni notevoli Previous: Regressione ortogonale a un

Il metodo applicato per ottenere la regressione lineare a una retta espressa in forma esplicita si può generalizzare a una qualunque funzione polinomiale del tipo:

|

(3.86) |

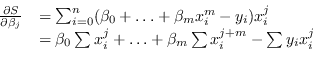

Il porre il gradiente nullo significa risolvere pertanto il sistema associato:

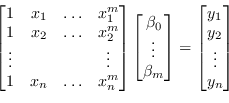

Alternativamente è possibile sfruttare la teoria della pseudoinversa (sezione 1.1) e usare direttamente l'equazione (3.85) per costruire un sistema lineare sovradimensionato:

|

(3.88) |

Come si vedrà in altre parti di questo libro, matrici come quella di Vandermonde, dove le diverse colonne hanno ordini di grandezza differenti, sono mal condizionate e richiedono una normalizzazione per migliorarne la stabilità numerica.

Paolo medici