Auto-Encoders

Gli Auto-Encoders sono particolari tipi di reti neurali non supervisionato che cercano di approssimare le RBM addestrate con l'algoritmo di Contrastive Divergence.

Un Auto-Encoders (e in questo le RBM sono una perfetta rappresentazione) permette di codificare l'ingresso  sotto forma di una rappresentazione

sotto forma di una rappresentazione

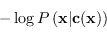

in modo che comunque l'ingresso possa in qualche modo essere ricostruito, minimizzando la negative log-likelihood

in modo che comunque l'ingresso possa in qualche modo essere ricostruito, minimizzando la negative log-likelihood

|

(4.87) |

È da notare che nel caso in cui la distribuzione fosse gaussiana si riotterebbe la classifica forma della regressione ai minimi quadrati (vedi sezione 2.8).

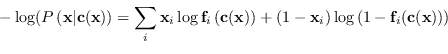

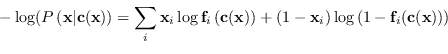

Quando invece gli ingressi  sono binari (o comunque la distribuzione è di tipo binomiale) allora la funzione costo diventa

sono binari (o comunque la distribuzione è di tipo binomiale) allora la funzione costo diventa

|

(4.88) |

dove

è il decoder associato all'encoder

è il decoder associato all'encoder

.

.

La funzione

è una funzione di compressione con perdita (lossy). Tale funzione è di fatto una buona compressione solamente per i dati visti durante la fase di addestramento non supervisionato ma non lo sarà per tutti i dati in generale non coinvolti nella fase di apprendimento.

è una funzione di compressione con perdita (lossy). Tale funzione è di fatto una buona compressione solamente per i dati visti durante la fase di addestramento non supervisionato ma non lo sarà per tutti i dati in generale non coinvolti nella fase di apprendimento.

Paolo medici

2025-03-12

![]() sono binari (o comunque la distribuzione è di tipo binomiale) allora la funzione costo diventa

sono binari (o comunque la distribuzione è di tipo binomiale) allora la funzione costo diventa

![]() è una funzione di compressione con perdita (lossy). Tale funzione è di fatto una buona compressione solamente per i dati visti durante la fase di addestramento non supervisionato ma non lo sarà per tutti i dati in generale non coinvolti nella fase di apprendimento.

è una funzione di compressione con perdita (lossy). Tale funzione è di fatto una buona compressione solamente per i dati visti durante la fase di addestramento non supervisionato ma non lo sarà per tutti i dati in generale non coinvolti nella fase di apprendimento.